Pyraformer:Low-Complexity-Pyramidal-Attention-for-Long-Range-Time-Series-Modeling and Forecasting

来自ICLR 2022 (oral) 的 工作 https://openreview.net/forum?id=0EXmFzUn5I

论文研究的主要背景

时序预测很重要 -> 现在RNN/CNN结构不太行 -> Transformer很牛逼 -> 改进的Transformer还做不到时空复杂度维 O(L)s

论文试图解决什么问题

如何降低attention机制的时间空间复杂度,同时进行准确的预测

主要贡献

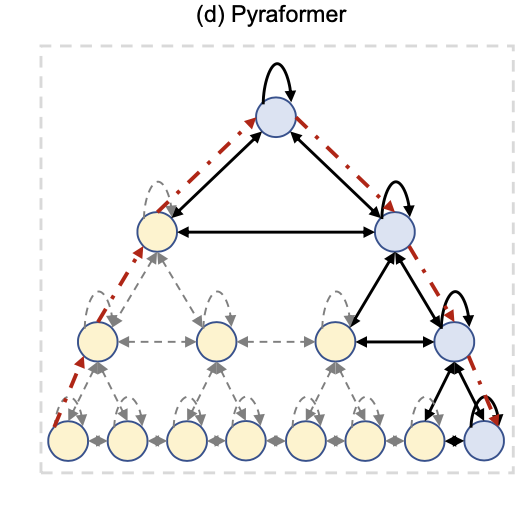

我们提出金字塔结构的注意力模型来同时捕获不同范围的时间依赖性。

从理论上证明,通过选择适当的参数,可以同时达到O(1)的最大路径长度和O(L)的时空复杂度。

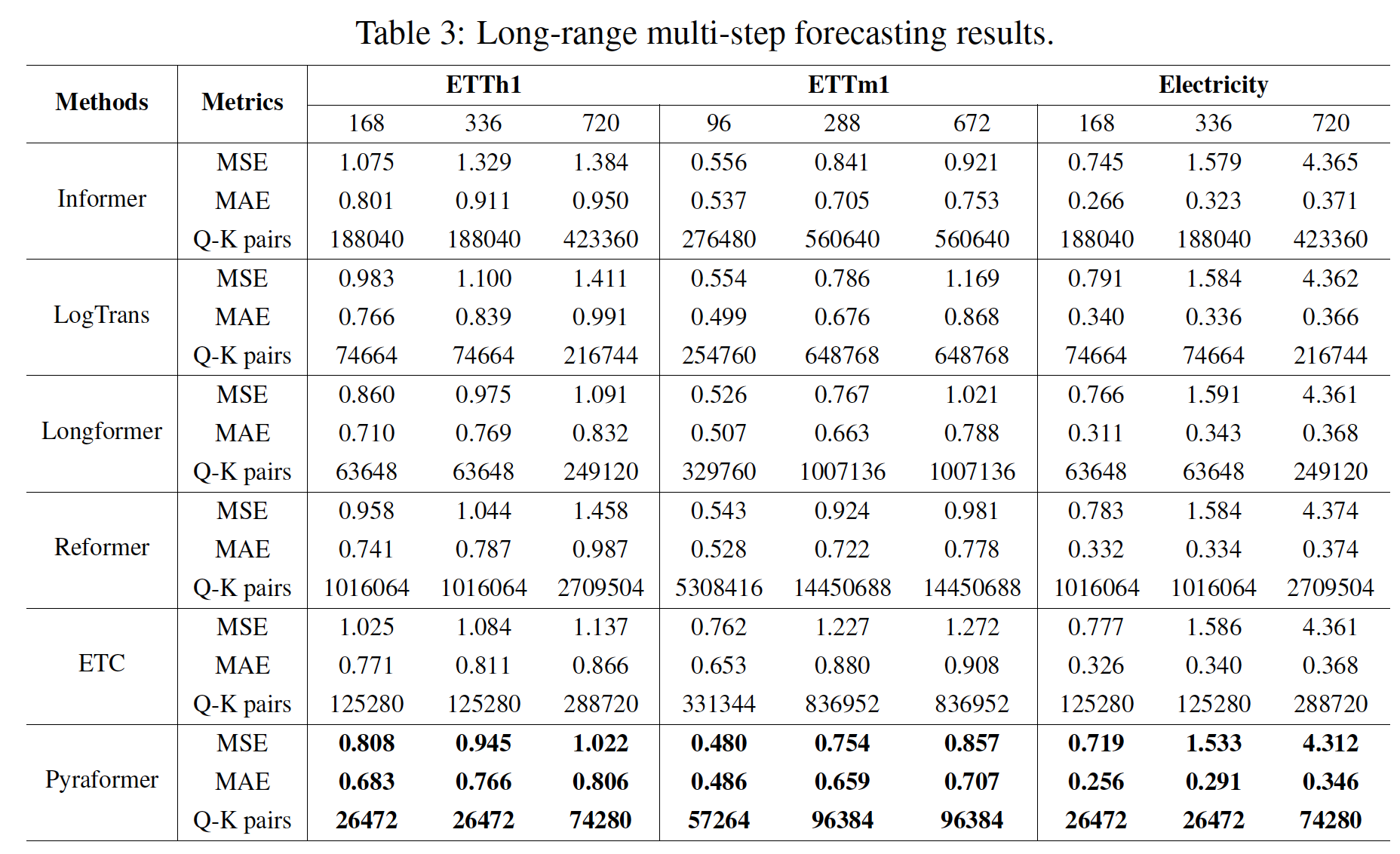

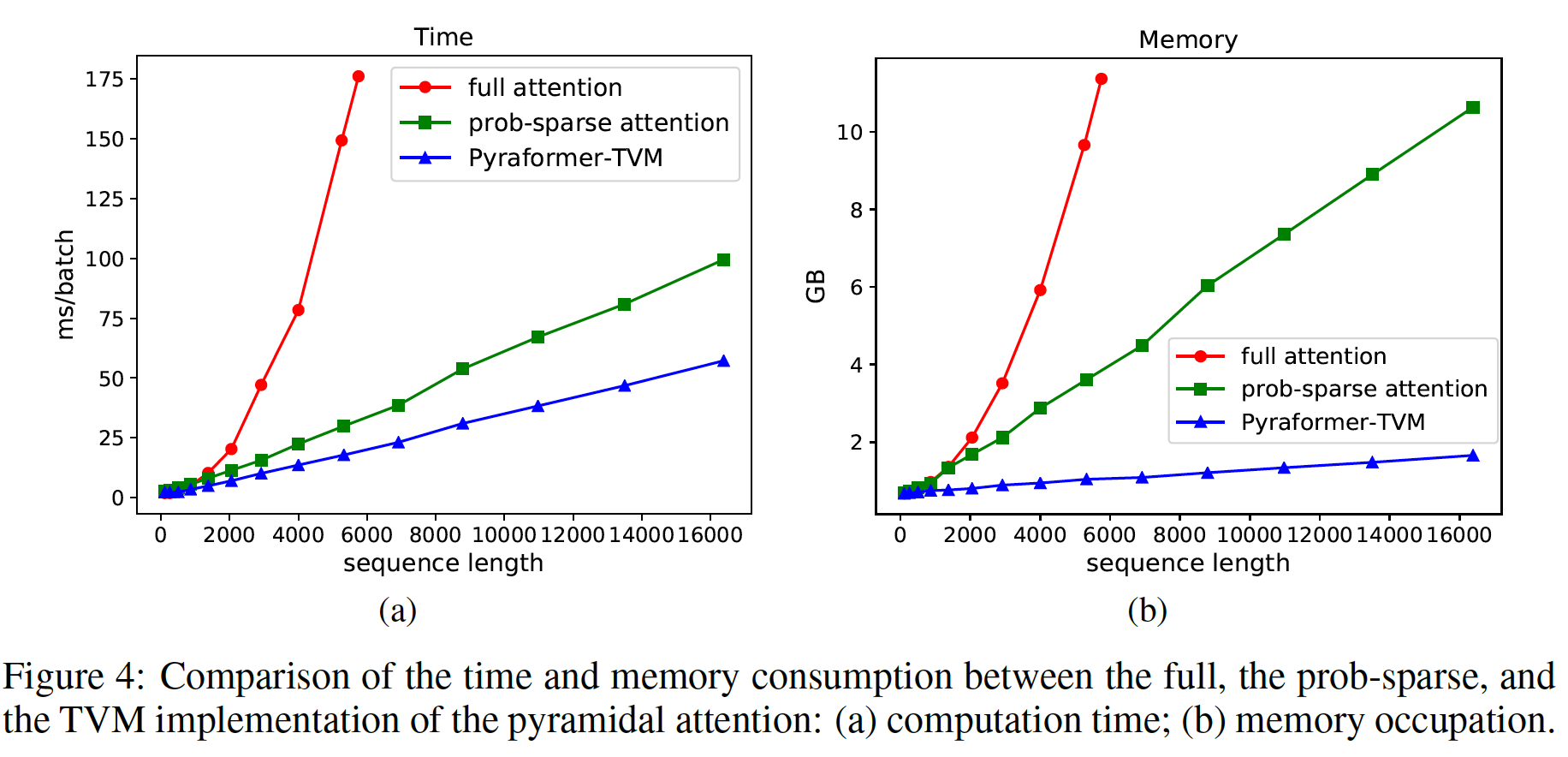

实验表明,在单步预测和多步预测的情况下,在各种真实数据集上,提出的Pyraformer比原来的Transformer及其变体产生更准确的预测,同时具有更低的时间和内存成本。

论文中提到的解决方案之关键是什么

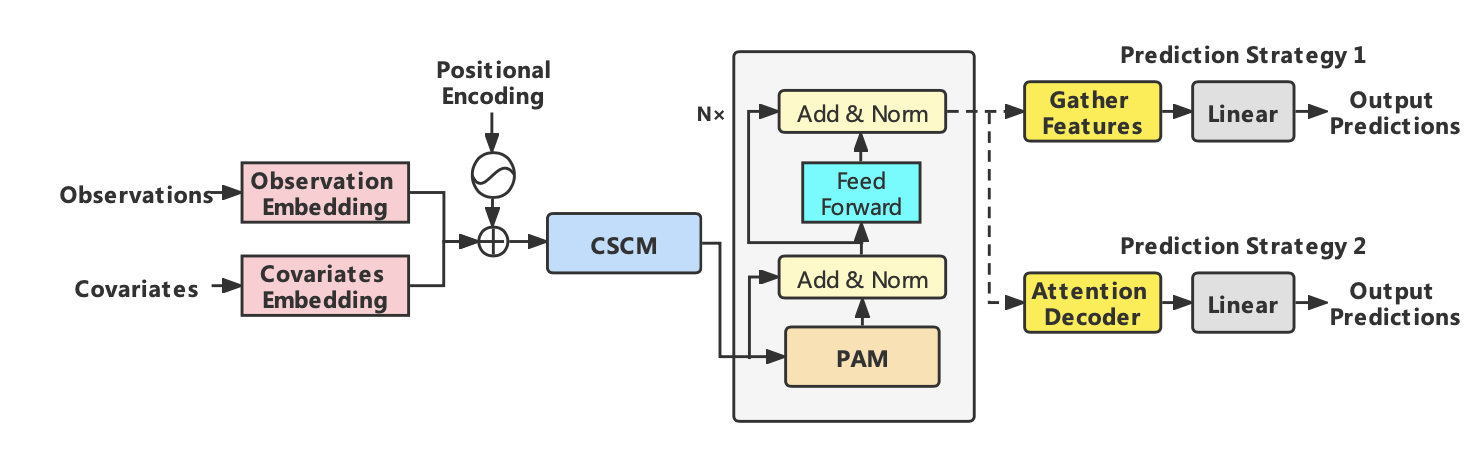

整体架构:

朴素的Transformer使用一个长的键值对来描述所有时间节点的特征关系

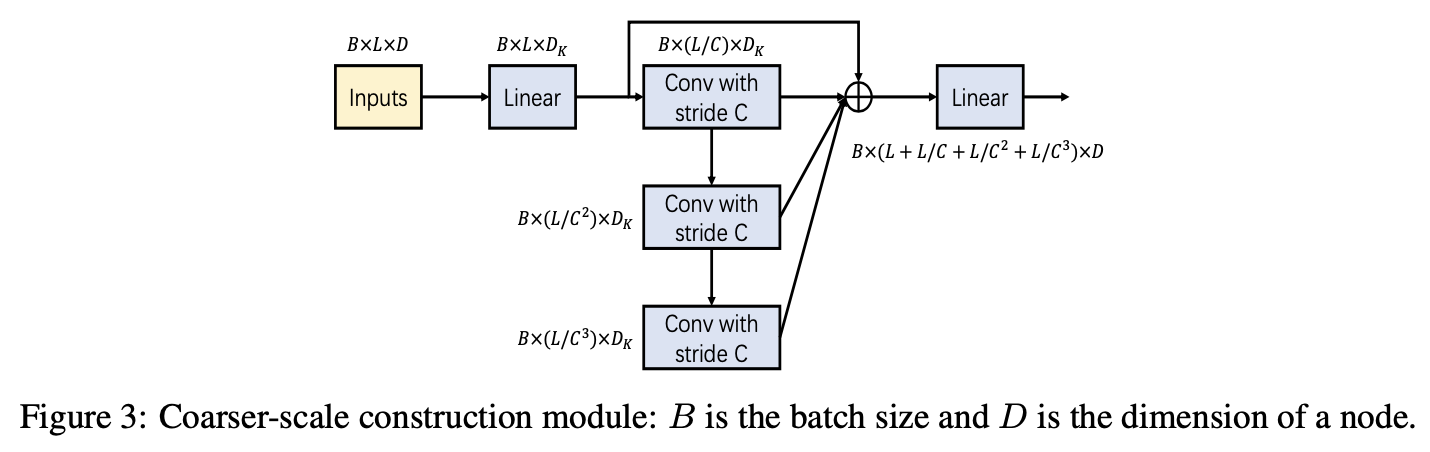

此外,有一个COARSER-SCALE CONSTRUCTION MODULE (CSCM) 模块,就是在不同的时序维度上进行卷积 [C1, C2, C3 …]

预测模块中,单步预测直接使用前面提到的模型,增加一个特征为0的时间节点,然后对他们embedding一下。多步预测第一种像单步的一样,只是改变最后的输出时序维度,第二种则和transformer一样,将需要预测时序,按照输出为零,结合前面的键值对来进行预测

论文中的实验是如何设计的?

应用电力、风能和APP 流量三种不同的数据集进行实验验证

相较于已有模型能够进行准确预测

同时进行了时间、内存开销,消融实验来验证模型的可靠性

论文中的实验及结果有没有很好地支持需要验证的科学假设?

从时间、内存开销角度取得了较大的提升

这篇论文到底有什么贡献?

一种可以用应用于时序领域的高效attention模型

from conclusion:

[在本文中,我们提出了一种新的金字塔注意模型,该模型能够有效地描述短时间和长时间依赖关系,并且具有较低的时间和空间复杂度。具体来说,我们首先利用CSCM构造了一个C-ary树,然后设计PAM来实现尺度内和尺度内的消息传递。当序列长度L增加时,通过调整C和固定其他参数,金字塔器可以实现理论复杂度O(L)和最大信号穿过路径长度O(1)。实验结果表明,该模型在单步和长期多步预测任务上均优于现有模型,但计算时间和内存开销较小。到目前为止,我们只关注在构建金字塔图时,A和S是固定的,C随着L的增加而增加。另一方面,我们在附录I中已经表明,超参数的其他配置可能会进一步改善金字塔器的性能。在未来的工作中,我们将探索如何从数据中自适应地学习超参数。此外,将Pyraformer扩展到其他领域也很有趣,包括自然语言处理和计算机视觉。]

缺点

没有代码开源,难以复现;

从工程的角度,算法的优化并没有特别突出,仅仅针对模型缺点进行了一些改进。

疑问

怎么去理解方法中提到的scale ? 这一概念导致特征维度难以理解 → 模型的输入和中间特征维度有待进一步阐述。

Pyraformer:Low-Complexity-Pyramidal-Attention-for-Long-Range-Time-Series-Modeling and Forecasting